Некоторые проблемы искусственный интеллект (ИИ) решает не так, как это сделал бы человек. Работу искусственного интеллекта необходимо поставить под контроль. Об этом заявили в комиссии по правовому обеспечению цифровой экономики московского отделения Ассоциации юристов России (АЮР). Об этом обращении 12 апреля написали Ведомости.

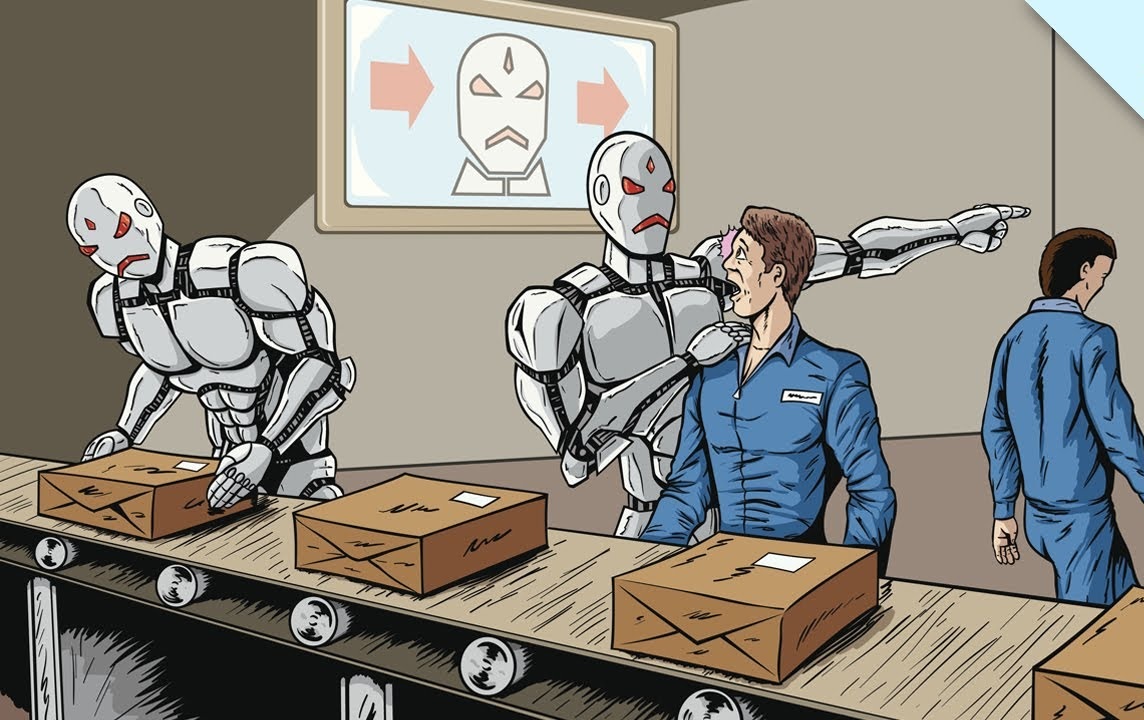

Деятельность ИИ сейчас не контролируется никакими законами. И это уже плохо сказывается на жизни граждан, считают в АЮР. Организация направила в Совет Федерации, Госдуму, Минцифры, Роскомнадзор обращения с предложением взять ИИ под юридический контроль.

В обращении сказано, что использование ИИ увеличивает риск дискриминации людей. В алгоритмах, используемых в ИИ, встречаются предубеждения, умышленно или нечаянно внесенные разработчиками. При принятии решений ИИ пользуется некачественными или неполными данными.

А найти ошибки и обжаловать решения машины сейчас очень трудно, потому что сторонних экспертов не допускают к ИИ-системам.

«В сфере госуправления системы алгоритмического принятия решений используются для привлечения к административной ответственности на основе данных видео- или фотофиксации, а также на основе иных технических данных – например, от сотовых операторов, – говорит МО АЮР. – Такого рода системы применялись для привлечения к ответственности весной прошлого года в Москве за нарушение режима самоизоляции. В СМИ фигурировало много курьезных случаев ошибочного привлечения к ответственности, например, парализованных граждан».

Часто ИИ не позволяет добросовестными гражданам брать кредиты, принимая решения на основании неверно интерпретированной информации и сырых алгоритмов. «При решении этого вопроса человеком оно могло бы быть иным», – говорит специалист, изучавший деятельность крупных компаний, использующих ИИ.

В АЮР предлагают разработать законы и для коммерческих организаций, использующих ИИ. По мнению Бориса Едидина, зампредседателя комиссии по правовому обеспечению цифровой экономики МО АЮР, в законодательстве предстоит изменить немногое. В частности, можно внести поправки в закон «О персональных данных»: «В нем можно прописать необходимость оценки ИИ-систем независимыми экспертами, предусмотреть на сайтах госструктур предупреждения о том, что на них используется ИИ, потребовать от внедряющих ИИ-системы предусматривать наличие запасного плана на случай сбоев и иных непредвиденных ситуаций».

В ведомствах сообщили, что изучают предложения АЮР. А вот в компаниях-разработчиках ИИ предложение юристов комментировать не хотят.

«Разработчики будут сопротивляться определению ИИ как объекта права изо всех сил – ведь в этом случае всю ответственность за его ошибки будут нести они, – говорит руководитель Content-Review Сергей Половников. – А в случае признания такой ответственности неизбежно встанет вопрос о компенсации убытков, связанных с некорректными решениями, принятыми ИИ».

Комментарий РВС

Предложение юристов можно только поддержать. Однако некоторые специалисты уверены, что проконтролировать сложные саморазвивающиеся системы, работающие с огромными базами данных, не всегда будет возможно. Уже сейчас один из идеологов цифровизации, спецпредставитель президента РФ по цифровому и технологическому развитию Дмитрий Песков открыто говорит о том, что ИИ – это некий черный ящик, логику принятия решений которого понять будет невозможно и придется только подчиниться этим решениям.