Специалист по кибербезопасности и безопасности ИИ, доктор наук, директор лаборатории кибербезопасности Университета Луисвилля Роман Ямпольский в 2019 году провел публичную лекцию «Искусственный интеллект и меры безопасности» (Artificial Intelligence Safety and Security). В прошлый раз мы писали о его опасениях по поводу всё большей простоты применения ИИ в дурных целях. В этом материале мы рассмотрим, какие возможности для обмана людей с помощью ИИ уже существуют.

«С моим опытом в области кибербезопасности я очень интересуюсь компьютерными вирусами и вредоносными программами в целом, и есть общая тенденция. Поскольку что у нас становится больше устройств, подключенных к Интернету, вирусы получают шанс. На самом деле, чем больше устройств, тем ущерб больше», — объяснил стандартную схему вирусной эффективности Ямпольский.

Особую опасность, по его словам, дает оbбъединение вредоносного программного обеспечения, подделывающего, например, голос, с возможностями социальной инженерии.

«Мы знаем, что атаки по методу социальной инженерии – самые ужасные, даже профессионалы на них клюют. У вас телефонный звонок от начальник, который говорит вам сделать то-то. Что вы будете делать? Или от вашей жены, по ситуации», — привел гипотетический пример специалист.

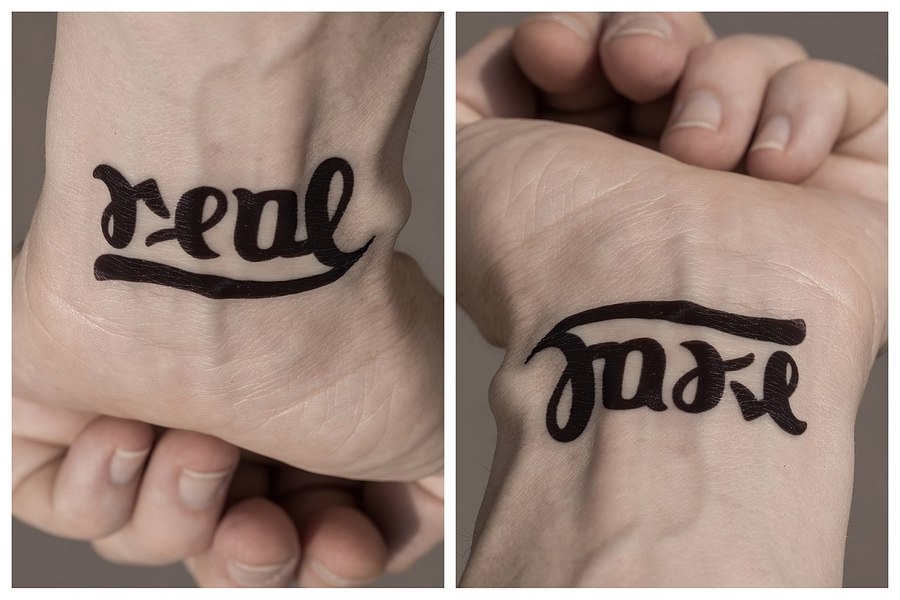

При этом получающиеся нейросетевые фальшивки, ИИ-фальшивки — deep fakes — очень тяжело отличить от реальности. «По сути, вы не в состоянии сказать, что является реальным, а что является фальшивкой, — это огромная лазейка для использования человека как самого слабого места в любой системе безопасности».

Разумеется, можно использовать такие технологии и в политической борьбе.

«Если вы можете создать поддельное видео, поддельный звук, поддельные фотографии, во что вы можете верить? Если всплывает политическое видео, вам показывают кандидатов, говорящих по-настоящему глупые вещи, то это настоящий президент или поддельный? Как вы распознаете? Это становится проблемой», — подчеркнул Ямпольский.

Причем часто не нужно даже сильно менять изображение, чтобы создать оптическую иллюзию, которая обманет человека — или машину. А этим машинам уже отдан контроль за многими жизненно необходимыми для человечества технологическими процессами. Об этом — в следующем материале.